RISC - Réseaux, Informatique, Systèmes de Confiance

Le département RISC « Réseaux, Informatique, Systèmes de Confiance » vise à développer des solutions innovantes permettant de maîtriser la conception, le dimensionnement, l’architecture, l’analyse, la supervision et le déploiement opérationnel de réseaux et systèmes communicants complexes et des applications associées. Nos recherches ciblent des systèmes et applications ayant des exigences fortes en termes de qualité de service, de contraintes temporelles, de sûreté de fonctionnement, de résilience ou de sécurité. Notre objectif est de contribuer à l’avancée des connaissances tant sur les fondements théoriques que sur les approches méthodologiques basées sur des méthodes formelles et expérimentales ainsi que sur leur mise en œuvre pratique.

Séminaires

|

Équipes de Recherche

Les activités sont menées au sein de quatre équipes dont les domaines de recherche sont complémentaires :

- Ingénierie Système et Intégration (ISI) : Lestravaux visent l’optimisation des processus d’intégration système et le co-pilotage des activités intervenant dans les projets d’ingénierie. L’accent est mis sur l’intégration de modèles hétérogènes en ingénierie des exigences et en conception, et la simulation et co-simulation de systèmes complexes basés sur des modèles.

- Services et Architectures pour les Réseaux Avancés (SARA) : Les recherches visent la maîtrise de la conception, planification, gestion du déploiement, et supervision des réseaux et des systèmes de communication de nouvelle génération et de leurs applications. Les contributions portent sur l’élaboration de méthodes, de modèles et d'outils, et la proposition d'architectures, de protocoles et de services.

- Tolérance aux fautes et Sûreté de Fonctionnement Informatique (TSF) : Les recherches portent sur le développement de méthodes, d’algorithmes, d’architectures et d’outils permettant d’assurer la sûreté de fonctionnement et la résilience de systèmes informatiques et de systèmes cyber-physiques, en considérant aussi des fautes d’origine accidentelle (du logiciel, du matériel, ou d’interactions humaines) ou intentionnelles (par exemple des intrusions)

- Vérification de Systèmes Temporisés CritiqueS (VERTICS) : L'objectif est d'accroître l'expressivité des techniques de description formelle des systèmes informatiques, en particulier celles qui gèrent les contraintes temporelles, d'améliorer les techniques de vérification des modèles et outils associés et de faciliter l'intégration de ces techniques formelles dans les processus d'ingénierie des systèmes.

Thèmes de recherche

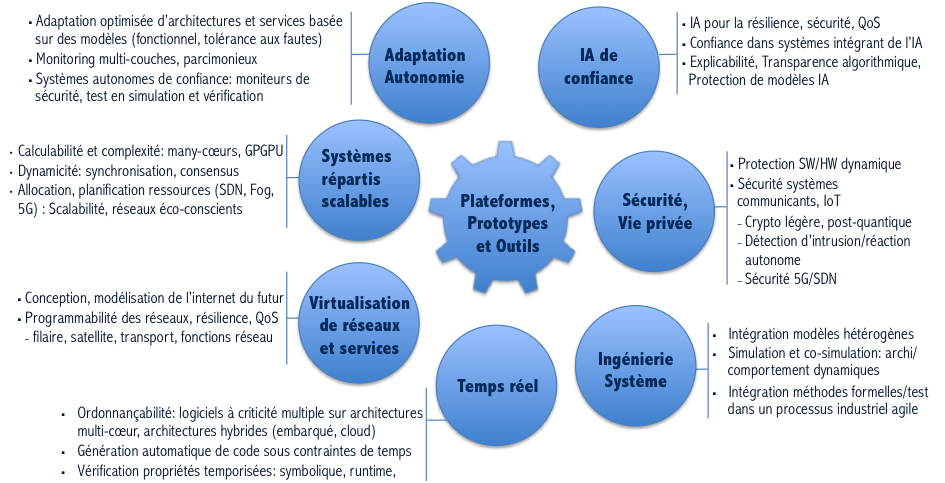

La figure suivante présente les thèmes de recherche explorés au sein du département RISC.

Objets et technologies cibles : Systèmes autonomes,Systèmes embarqués,Infrastructures critiques, Temps réel, Internet des objets (IoT), M2M, communications sans fil, communications par satellite/5G, Virtualisation (Cloud, SDN, NFV, Edge computing, 5G)

Domaines d’application : Transports (aéronautique, automobile), Télécommunications, Industrie 4.0, Espace, Energie, Défense, Ville intelligente, Réseaux sociaux et applications Web

Les orientations principales de nos thèmes de recherche sont résumées ci-dessous.

Adaptation - Autonomie : il s’agit de développer des architectures et services dotés de la capacité d’anticiper des changements dans le contexte d’exécution et de s’adapter et de se reconfigurer dynamiquement afin de satisfaire les propriétés requises. Les orientations de recherche concernent le développement de techniques avancées de monitoring, couvrant différentes couches de l’architecture tout en recherchant un compromis optimal entre le niveau de granularité, la précision des résultats, et le surcoût en performances. L’utilisation de techniques d’intelligence artificielle sera mise à profit dans cet objectif. La recherche portera aussi sur le développement de modèles permettant une gestion optimisée de l’adaptation selon différents points de vue. Nos travaux sur l’adaptation concernent différents niveaux de l’architecture des systèmes, incluant également les mécanismes de tolérance aux fautes qui sont conçus pour assurer la détection et le recouvrement d’erreurs. Un dernier volet de nos travaux concerne la conception de mécanismes de résilience pour des systèmes autonomes critiques et la problématique du test de ces systèmes dans des environnements virtuels, en mettant l’accent notamment sur la sélection optimale des cas de test.

Systèmes répartis scalables : Un premier volet de nos recherches vise à explorer les fondements de l'algorithmique répartie sur les nouvelles architectures, et en particulier l'extension des outils de la topologie algébrique permettant de caractériser calculabilité et complexité d'algorithmes s'exécutant sur des systèmes répartis à interconnexion complexe. Le premier axe est de passer des architectures multi-cœurs –les seules architectures étudiées dans les approches utilisant la topologie algébrique– aux many-cœurs ou GPGPU. Le second axe se focalise sur les systèmes répartis dynamiques, en évolution, et investigue de manière formelle les liens entre les motifs d'évolution de la connectivité d'une infrastructure et la puissance de calcul atteignable par le système réparti résultant ; on étudiera en particulier la faisabilité de mécanismes de synchronisation classiques (type consensus ou sous-consensus), afin de permettre l’implémentation de services fiables malgré les changements dans la topologie d'interconnexion des ordinateurs. Un deuxième volet de nos perspectives concerne le développement d’algorithmes permettant l’optimisation d'allocation dynamique de ressources dans les réseaux, par exemple dans le cas du dimensionnement et de la planification de ressources pour des infrastructures basées sur le modèle Fog Computing, ou bien l’allocation dynamique de canaux dans des réseaux cellulaires destinés aux véhicules connectés. Fournir des stratégies d’ordonnancement et d’allocation de ressources économes en énergie devient un objectif majeur et sous étudié. Enfin, nos recherches visent également la mise à l'échelle des réseaux et services déployés sur les infrastructures du futur, en particulier basées sur des SDN (Software-Defined Networks). Un accent particulier sera mis sur les techniques de calcul combinant efficacement processeurs multi-cœur et accélérateurs GPU.

Virtualisation de réseaux et services : Nos recherches sur ce thème portent sur la modélisation, la conception et la mise en œuvre des futures architectures de l’Internet, qui seront basées sur des infrastructures de communication virtualisées et reconfigurables, dans un environnement hétérogène et évolutif, avec des exigences très élevées en termes de programmabilité, de résilience et de qualité de service. Un autre aspect de nos travaux concerne l’utilisation de la virtualisation comme support pour la mise en œuvre de plateformes expérimentales permettant l’émulation de systèmes distribués complets sur toute la pile architecturale, matérielle et logicielle.

Temps réel : Le premier volet de nos recherches étudie l’ordonnançabilité d’applications à criticité multiple, sur des architectures multi-cœur embarquées. La variabilité des temps d'exécution inhérente à de telles architectures est par essence contradictoire avec le besoin de prédictibilité des systèmes temps réels ; la criticité multiple des futurs systèmes peut permettre d'offrir un levier pour garantir l'ordonnançabilité des niveaux les plus critiques au détriment des niveaux de criticité moindre. Le second volet porte sur les nouvelles architectures hybrides, et en particulier les véhicules connectés qui collectent et exploitent collectivement, via une infrastructure Cloud, les données issues de capteurs embarqués sur la flotte de véhicules. La problématique concerne l’ordonnancement et l’optimisation des transferts de données en respectant les contraintes temporelles et spatiales. Un troisième volet aborde la génération de code fidèle sous contraintes de temps. Cette problématique consiste à développer des méthodes pour produire des exécutables dont le comportement est temporellement identique à celui d'un modèle de haut-niveau. Enfin, le quatrième volet vise le développement de modèles plus expressifs et d’algorithmes plus efficaces pour la vérification formelle de propriétés temporisées. Nous nous intéressons au développement de nouvelles méthodes de vérification symbolique ainsi qu’à l’étude de problèmes à l’interface entre la « vérification formelle », liée au runtime monitoring de propriétés temps réel, et la théorie de la contrôlabilité des systèmes à événements discrets.

Sécurité et protection de données personnelles : Un axe majeur de nos travaux porte sur le développement de nouvelles architectures pour améliorer la sécurité des processeurs en s’appuyant sur une solution mixte intégrant des mécanismes de protection matériels et logiciels, reconfigurables dynamiquement. Ces travaux seront complétés par le développement de solutions basées sur la cryptographie légère et post-quantique dédiées à renforcer la protection de systèmes embarqués par exemple pour l’Internet des objets (IoT) vis-à-vis d’attaques par canaux auxiliaires. Dans le domaine de l’IoT et plus généralement de la sécurité réseau, notre effort sera porté vers des approches de détection d’anomalies combinant des informations multi-couches (de la couche physique mais également des couches réseaux supérieures), utilisant des techniques distribuées d’estimation prédictives (notamment par apprentissage). Un autre défi important est d'envisager de rendre les systèmes encore plus autonomes face aux attaques en intégrant des mécanismes de réaction associés à la détection. Enfin, un axe transverse concernera les mécanismes de protection des données personnelles compatibles avec la RGPD, nécessaires pour les projets du département utilisant des données personnelles.

Intelligence artificielle de confiance : Les algorithmes d’intelligence artificielle (IA) et les modèles d’apprentissage basés sur des données sont de plus en plus utilisés dans tous les domaines. Un premier volet de nos travaux vise à tirer profit des dernières avancées en IA pour améliorer la résilience et la qualité de service des réseaux et des systèmes informatiques dans divers domaines (monitoring, détection et diagnostic d’anomalies et d’intrusion, test, etc.). Le deuxième volet s’attaque à des questions fondamentales liées à la confiance que l’on peut placer dans les systèmes utilisant ces algorithmes en prenant en compte les contraintes propres à ces algorithmes (opacité, non-déterminisme, sensibilité aux données d’apprentissage, etc.). Les défis sont relatifs à la recherche de solutions permettant d’améliorer l’explicabilité de ces algorithmes, leur vérification et test, leur protection vis-à-vis d’attaques visant à modifier leurs comportements, ou simplement à les reproduire de façon illégitime, et enfin la justification du niveau de confiance associé.

Ingénierie de systèmes complexes : Nos travaux visent le développement de méthodes permettant d’optimiser les processus d’intégration système et le co-pilotage des activités intervenant dans les projets d’ingénierie. L’accent est mis sur l’intégration de modèles hétérogènes en ingénierie des exigences et en conception, et la simulation et co-simulation de systèmes complexes basés sur des modèles. Les évolutions des pratiques industrielles vers des développements plus agiles, itératifs et incrémentaux nécessitent la définition de nouvelles approches d’ingénierie et de test à ce nouveau contexte d’intégration continue.

Plateformes, Prototypes et Outils : Plusieurs de nos travaux se concrétisent par la mise en œuvre de prototypes, d’outils et de preuves de concepts afin de valider nos approches. Un effort conséquent est dédié à des expérimentations dans le domaine des objets connectés couvrant différents aspects, par exemple autour de la plateforme OM2M qui vise à offrir une architecture opérationnelle flexible et extensible pour une meilleure interopérabilité d’objets connectés utilisant des protocoles hétérogènes, et de la plateforme CLUE qui a été conçue pour étudier la mobilité et les interactions sociales notamment dans des foules. Des développements se poursuivront également sur la suite d’outils de vérification de modèles basés sur TINA et FIACRE, et sur l’outil de simulation à événements discrets ProjectDEVS.